台研究團隊AI突破性發展 打破決策黑盒子

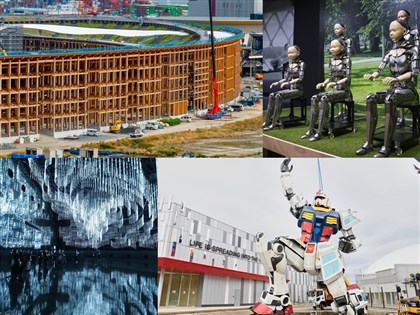

(中央社記者潘姿羽台北11日電)台灣團隊在人工智慧(AI)領域有重大突破,台大AI中心轄下徐宏民教授團隊發表開發出的可解釋性人工智慧模組xCos,除了具備高辨識率的人臉辨識能力,更可以有條理的解釋AI產出結果的原因,揭開AI決策的黑盒子。

國際知名公司資誠聯合會計師事務所(Pwc)曾在研究報告指出,人工智慧具有15兆美元的市值,但當前關卡就是AI缺乏解釋性。

科技部指出,現階段AI只看到輸入的資料以及輸出的結果,中間判斷依據與過程難以捉摸,如同黑盒子一般,如果能理解AI如何做出判斷,確認決策的合理性,未來才能進一步改善與強化模型可靠性,並強化人類對於AI的信任度。

科技部長陳良基舉例,如果說一個人很帥,會用身高、眼睛、鼻子、身材等指標來做判斷,但AI判定參數可能達上億個,AI要如何從上億參數當中,決定哪個比較重要,就是外界過去想要參透的AI決策黑盒子,進而判定AI的決策是否能夠信賴。

因此,科技部指出,可解釋性人工智慧(Explainable AI ,XAI)成為近年來各國AI研究領域的趨勢之一,包含美國國防高等研究計畫署(DARPA)於2018年宣布投入20億美元推動的AI計畫中,AI的可解釋性就是其中重要的一環。

科技部今天特別舉辦「打破AI黑盒子-可解釋性的人臉辨識模組」記者會,宣布這項科研重要突破,並邀請台灣大學人工智慧技術暨全幅健康照護聯合研究中心(台大AI中心)轄下徐宏民教授團隊,發表團隊在科技部的支持下,所開發出的可解釋性人工智慧模組xCos,這個模組除了具備高辨識率的人臉辨識能力,可以跨年紀、抗偽裝,還可有條理的解釋AI產出結果的原因。

徐宏民指出,可解釋性人工智慧模組xCos可以成功解釋為何兩張人臉會辨識為同一人或另一人的原因,提出AI黑盒子的決策依據、協助人臉辨識產品開發,同時xCos會自動留意人臉不自然的表面,而專注在真實以及具辨識能力的人臉位置,進而達到偽裝人臉辨識的效果;且經過測試,就算搭配不同的人臉辨識軟體,也能發揮同樣的功能。

陳良基表示,他對於研究成果「非常驚豔」,這是全世界在AI領域夢寐以求要解決的問題,不只是技術精進,而是掌握全世界未來發展重要趨勢;期待徐宏民教授團隊的成果發表,能夠讓全世界看到台灣在AI的重要性。

徐宏民也說,這套XAI模組xCos除了可供末端的使用者了解人臉辨識結果的原因,更可協助開發人員探究及檢視系統的運作機制,未來希望將相關理念拓展至其他深度學習相關應用中,同時正將XAI技術擴展到其他領域關鍵性的人工智慧決策系統,促進國內外AI技術與相關產業進展。(編輯:鄭雪文)1090511

本網站之文字、圖片及影音,非經授權,不得轉載、公開播送或公開傳輸及利用。

![鄭宗哲時速162公里強勁擊球遭美技沒收 大聯盟首安再等等[影]](https://imgcdn.cna.com.tw/www/webphotos/WebCover/420/20250412/869x652_688865195671.jpg)

請輸入正確的電子信箱格式

請輸入正確的電子信箱格式